תקציב סריקה הוא מספר הדפים שגוגל תסרוק באתר במהלך פרק זמן נתון.

חשוב לנהל את תקציב הסריקה ביעילות מכיוון שהוא יכול להשפיע על מידת האינדקס של הדפים ועל כמה מהר כל העדכונים שתבצע באתר יבואו לידי ביטוי בתוצאות החיפוש.

כמה טיפים לניהול תקציב הסריקה:

ודא שלאתר יש היררכיה ברורה:

השתמש במבנה ברור והגיוני כדי לארגן את הדפים, כאשר הדפים החשובים ביותר קרובים יותר לדומיין השורש.

זה יעזור לגוגל להבין את החשיבות היחסית של הדפים ולתעדף אותם בהתאם.

השתמש במפות Site:

מפת אתר היא קובץ שמפרט את כל הדפים באתר ועוזר לגוגל לגלות אותם.

על ידי שליחת מפת אתר ל-Google, תוכל להבטיח שכל הדפים ייסרקו.

השתמש בהנחיות סריקה:

אתה יכול להשתמש בהנחיות סריקה כגון robots.txt ובתג “noindex” כדי לומר לגוגל אילו דפים לסרוק ומאילו להתעלם.

זה יכול לעזור לך למקד את תקציב הסריקה בדפים החשובים ביותר.

תקן שגיאות סריקה:

אם Google נתקלת בשגיאות בעת סריקת האתר, היא עשויה להאט את קצב הסריקה.

השתמש ב-Google Search Console כדי לזהות ולתקן שגיאות סריקה כדי להבטיח ש-Google תוכל לסרוק את האתר ביעילות.

מעקב אחר קצב הסריקה הוא קריטי.

אחזור robots.txt מתאר אם גוגל נתקלה בבעיות בבקשת קובץ robots.txt בעת סריקת האתר.

קיימת בעיה בקישוריות כאשר מספר השגיאות בבקשת האחזור חורג בהגזמה ממספר הבסיס לאותו היום.

אחזור מוצלח פירושו שקובץ ה-robots.txt אוחזר בהצלחה (200) או שהקובץ לא קיים (404).

כל שאר התגובות נחשבות כשגיאת אחזור.

האפשרות פענוח DNS מתארת אם Google נתקלה בבעיות DNS בעת סריקת האתר.

שיעורי השגיאות של ה-DNS נחשבים לבעייתיים אם הם חורגים מערך הבסיס לאותו היום.

האפשרות קישוריות שרת מציינת אם Google נתקלה בבעיות קישוריות במהלך סריקת האתר.

שיעורי שגיאות הקישוריות נחשבים לבעייתיים אם הם חורגים מערך הבסיס לאותו היום.

מהו תקציב סריקה?

תקציב סריקה הוא מספר הדפים שגוגל תסרוק באתר במהלך פרק זמן נתון.

זהו משאב מוגבל, וחשוב לנהל אותו ביעילות מכיוון שהוא יכול להשפיע על מידת האינדקס של הדפים וכמה מהר כל העדכונים שתבצע באתר יבואו לידי ביטוי בתוצאות החיפוש.

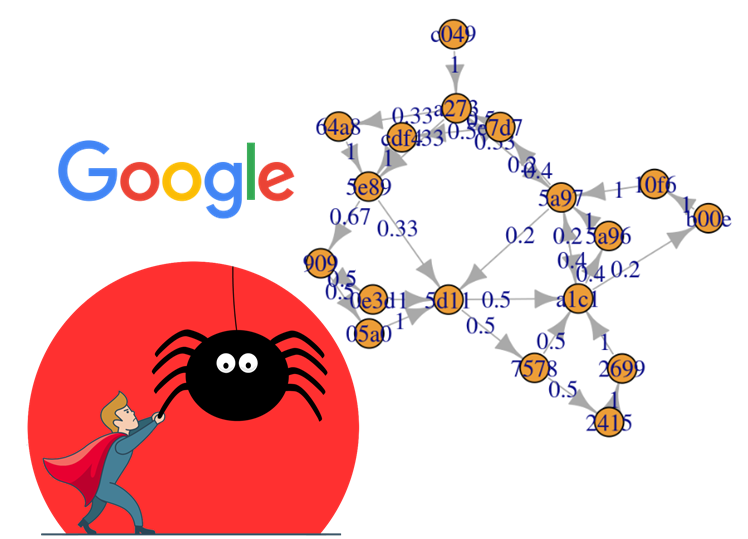

גוגל משתמשת בתוכנות אוטומטיות הנקראות “סורקים” או “עכבישים” כדי לגלות ולסרוק דפים חדשים ומעודכנים באינטרנט.

כאשר סורק מבקר באתר, הוא עוקב אחר קישורים לדפים אחרים באתר ומוסיף אותם לתור של דפים לסריקה.

תקציב הסריקה הוא מספר הדפים שגוגל תסרוק מהאתר במהלך פרק זמן מסוים, כגון יום או שבוע.

כדי לנהל את תקציב הסריקה בצורה יעילה, חשוב להבטיח ש-Google תוכל למצוא ולסרוק בקלות את הדפים החשובים ביותר באתר.

ניתן להשיג זאת באמצעות היררכיית אתרים ברורה והגיונית, שימוש במפות אתרים והנחיות סריקה ופתרון שגיאות סריקה.

ניטור קצב הסריקה באמצעות כלים כגון Google Search Console יכול גם לעזור לך לזהות בעיות ולבצע התאמות לפי הצורך.

בעיות ובעיות בתקציב הסריקה

ישנן מספר בעיות ובעיות שעלולות להתעורר אם אינך מנהל את תקציב הסריקה ביעילות:

אינדקס לקוי:

אם Google לא סורקת את הדפים החשובים, ייתכן שהם לא יוכנסו לאינדקס ולכן לא ייכללו בתוצאות החיפוש.

מאוד משפיע על הנראות והתנועה של האתר.

עדכונים איטיים:

אם Google לא סורקת את האתר בתדירות מספקת, ייתכן שיחלוף זמן רב יותר עד שכל העדכונים שתבצע יבואו לידי ביטוי בתוצאות החיפוש.

די מתסכל עבור משתמשים שמחפשים את המידע העדכני ביותר.

בזבוז תקציב סריקה:

אם גוגל סורקת דפים באיכות נמוכה או לא חשובים, היא מבזבזת תקציב סריקה שיכול לשמש טוב יותר בדפים חשובים יותר.

זה יכול להשפיע על האפקטיביות הכוללת של תקציב הסריקה.

שגיאות סריקה:

אם Google נתקלת בשגיאות בעת סריקת האתר, גוגל עלולה להאט את קצב הסריקה של הבוטים או אפילו להפסיק את סריקת האתר לחלוטין.

זה יכול להשפיע על ההוספה והנראות של הדפים.

כדי להימנע מבעיות אלו, חשוב לנהל את תקציב הסריקה בצורה יעילה על ידי התמקדות בדפים החשובים ביותר, שימוש במפות Site והנחיות סריקה כדי להדריך את הסורקים של Google, ותיקון כל שגיאות סריקה בהקדם האפשרי.

סורקי גוגל

סורקי גוגל, הידועים גם בשם Googlebots, הם תוכנות אוטומטיות שמחפשות באינטרנט ומגלות דפים חדשים ומעודכנים שיוסיפו לאינדקס החיפוש של גוגל.

המטרה העיקרית של הסורקים היא לסרוק את האינטרנט ולאסוף מידע על דפי אינטרנט, לרבות המילים בדף, הקישורים לדפים אחרים, וכל מידע אחר שעשוי להיות רלוונטי לתוכן ולמטרת העמוד.

סורקים משתמשים באלגוריתמים כדי לקבוע אילו דפים לסרוק ובאיזו תדירות לסרוק אותם.

הם עוקבים אחר קישורים מדף אחד לאחר ומוסיפים את הדפים שהם מגלים לתור של דפים שיסרוקו.

המידע שהסורקים אוספים משמש ליצירה ולעדכון של אינדקס החיפוש של גוגל, שהוא מסד נתונים מאסיבי של כל דפי האינטרנט שהתגלו והוספו לאינדקס על ידי הסורקים.

לסורקים תפקיד מכריע בתפקוד מנוע החיפוש של גוגל, שכן הם מסייעים להבטיח שאינדקס החיפוש יהיה מקיף ועדכני.

זה מאפשר למשתמשים למצוא מידע רלוונטי ומדויק כאשר הם מחפשים מילות מפתח או ביטויים.

סוגים של סורקי גוגל

ישנם מספר סוגים של סורקי Google, כולל:

Googlebot:

זהו הסורק הראשי המשמש את Google לגילוי והוספת דפי אינטרנט לאינדקס. Googlebot יכול לסרוק גם דפים שולחניים וגם דפים לנייד.

Googlebot News:

סורק זה תוכנן במיוחד כדי לגלות ולהוסיף מאמרי חדשות. הוא משמש להפעלת חדשות Google ותכונות חיפוש אחרות הקשורות לחדשות.

תמונות Googlebot:

סורק זה תוכנן במיוחד לגילוי והוספת תמונות לאינדקס.

משמש להפעלת תמונות Google ותכונות חיפוש אחרות הקשורות לתמונה.

וידאו של Googlebot:

סורק זה תוכנן במיוחד כדי לגלות ולהוסיף סרטונים לאינדקס.

משמש להפעלת Google Video ותכונות חיפוש אחרות הקשורות לווידאו.

Googlebot Mobile:

סורק זה תוכנן במיוחד כדי לגלות ולהוסיף לאינדקס דפים לנייד.

משמש כדי להבטיח שהגרסה הניידת של אינדקס החיפוש של גוגל תהיה מקיפה.

לכל אחד מהסורקים הללו יש פונקציה ספציפית והוא נועד לגלות ולהוסיף סוגים שונים של תוכן.

גוגל משתמשת במגוון סורקים כדי להבטיח שאינדקס החיפוש יהיה מקיף ומעודכן.

דוג’ לסורק בpython

סורק אינטרנט ב-python

סורק אינטרנט הוא תוכנית המבקרת בדפי אינטרנט ואוספת מידע עליהם. ב-Python, אתה יכול להשתמש בספריית הבקשות כדי לבצע בקשות HTTP לדפי אינטרנט ובספריית BeautifulSoup כדי לנתח את תוכן ה-HTML או ה-XML של הדפים.

דוגמה לסורק אינטרנט פשוט ב- Python שמתחיל בכתובת אתר נתונה ועוקב אחר קישורים לדפים אחרים:

דוגמה זו משתמשת בספריית הבקשות כדי לבצע בקשת GET לכתובת האתר הנתונה ובספריית BeautifulSoup כדי לנתח את תוכן ה-HTML של הדף.

לאחר מכן, הוא מוצא את כל האלמנטים (קישורים) בדף ועוקב אחר כל אחד מהם על ידי קריאה רקורסיבית לפונקציית הסריקה.

ניתן להתאים אישית את סורק האינטרנט הבסיסי הזה על ידי הוספת תכונות נוספות כגון אחסון הנתונים שנסרקו במסד נתונים, הגבלת מספר הדפים שנסרקו או הימנעות מסריקת סוגים מסוימים של דפים.

import requests

from bs4 import BeautifulSoup

def crawl(url):

# Make a request to the URL

response = requests.get(url)

# Parse the HTML or XML content

soup = BeautifulSoup(response.content, 'html.parser')

# Find all the links in the page

links = soup.find_all('a')

# Follow each link

for link in links:

href = link.get('href')

# If the link is a relative URL, convert it to an absolute URL

if href.startswith('/'):

href = url + href

# Crawl the linked page

crawl(href)

# Start the crawl at a specific URL

crawl('https://www.example.com/')